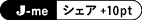

最近、ますます進化する音楽とAIの関係を、ポップカルチャージャーナリストのJun Fukunagaが解説した。

Fukunagaが登場したのはJ-WAVEで放送された番組『SONAR MUSIC』(ナビゲーター:あっこゴリラ)。オンエアは3月15日(水)。

【SONAR MUSICは番組公式LINEでも情報発信中! 登録はコチラ】

https://page.line.me/181xnepk?openQrModal=true

まずFukunagaは「デヴィッド・ゲッタ、AIと音楽の関係について持論を語る」というトピックを紹介した。

有名EDMプロデューサーでDJのデヴィッド・ゲッタは、AIが生成したラッパーのエミネムの声を使用した楽曲『Emin-AI-em』を紹介する動画をSNSで公開したことで注目を集めた。

あっこゴリラ:これめちゃくちゃ話題になりましたよね。

Fukunaga:結局、議論も呼び起こしていて、その動画でデヴィッド・ゲッタは、AIが作ったエミネムの楽曲について「エミネムの音声はAIを使用したんだけど、冗談で作ったものだ」と説明してるんです。この曲はデヴィッド・ゲッタが出演したあるイベントでプレイされているんですけど、今後商業ベースで使用されることはないと言っています。彼自身はAIを音楽制作の道具として利用することに肯定的なんですよね。新しい音楽制作スタイルを生み出す可能性があると考えているんです。ただ、アーティストのセンスに代わるものではなくて、あくまで道具として利用するべきだとも述べています。ただ、AIを使うことにアーティストでも賛否両論あるんですよね。

あっこゴリラ:それはそうですよね。

Fukunaga:例えば、大御所アーティストのニック・ケイヴとかは否定的な見解を示しています。とはいえ音楽の歴史を振り返っていくと、ローランドのTR-808が出てきたりとかで新しいテクノロジーが導入されたことで生まれた音楽スタイルってあるじゃないですか。まさにヒップホップとかトラップとかも正にそうだと思うんですけど。だからデヴィッド・ゲッタが言うようにAIにもそういうことが起きうるはずだって感じなんですよね。

あっこゴリラ:確かに。人類ってもうAIなしの生活は厳しいんじゃないかなって。できるとは思うんだけど、効率化する上でもかなりいいし。だからポジティブになるべく仲よくやっていきたいですよね。でも気をつけないといけないのはAIに食われないことですよね(笑)。そこだけはマジで気をつけながらっていうのがポイントかなって。でもそこで新しい音楽スタイルが生まれるのはちょっと楽しみですよね。何が生まれるのかなって。

中国のTencent Music Entertainment(TME)が、人間の声を模倣したAIによるボーカルをフィーチャーしてリリースした楽曲が、1億回ストリーミング再生を突破したことを発表した。

Fukunaga:ちなみにSpotifyで1億回のストリーミングをされたときの収益は役4,763万円相当って言われています。

あっこゴリラ:スゴすぎる。

Fukunaga:TMEの音楽部門ってこれまでにAIボーカルをフィーチャーした曲を1000曲以上出してるそうで、そのうちの『Today(英題)』という曲、それが1億回以上ストリーミングされた最初のAIの曲になったとのことなんです。またTMEは2022年11月の段階で、中国の音楽シーンにおけるスターの声を使ったAI歌手のラインナップ確立に取り組むことも発表したりもしているんです。同様の動きとして、BTSが所属しているHYBEがAI音声デベロッパーの会社を買収したこととかもあったりして、この辺も今後どんどん動いていきそうな業界の話ですね。

あっこゴリラ:なるほど。

Fukunaga:こういういわゆるディープフェイクみたいなものはまだ倫理とか法律の問題もあるので、今生きている人の声を勝手には使うことができないっていうことがあって。さっきのデヴィッド・ゲッタの話もそうで、これで商業リリースはできていない気はするんですよね。

あっこゴリラ:人ごとじゃないっていうか。私も声の商売なので、勝手に使われるってなると「ちょっと待て」ってなってきちゃいますよね。

「こうなるとボカロもどうなるのかと」とあっこゴリラがFukunagaに質問する。

Fukunaga:ボカロもCeVIO AIってAIの人口合成音声を出すっていうものがすでにあるので、利用者も多いんじゃないですかね。

あっこゴリラ:マジでターミネーターじゃんって気がする。音楽業界がターミネーター化してるっていうか。

Fukunaga:意外と音楽業界ってあまり気にしてないだけで、AIってみんな使ってるんですよね。例えばサブスクのパーソナライズとかもそうですし、音楽を作るときのプラグインとかもAIのアシストツールが付いてたりするので。

あっこゴリラ:だからトレンドだけ追いかけてたらAIに取って変わられる気はしますね。

Fukunaga:Googleの研究部門にGoogle Researchっていうところがあって、そこが今年公開したツールなんですけど、入力された文章に応じてAIが音楽を自動で生成するというツールです。28万時間に及ぶ音楽のデータセットを用いて学習したAIが使われていて、Googleは非常に複雑なテキストからでも忠実生の高い音楽が作り出せると言っています。例として「ディストーションの効いたギターリフのバッキングにのった心地よいバイオリンの旋律」みたいな複雑な文章にも対応するとされてるんですよ。

あっこゴリラ:「むせび泣くような」とか、感情的な部分も反応してくれるんですか。

Fukunaga:そういうのもやってて、このMusicLMはテキストとメロディーの両方を条件とすることができるんですよ。文章のキャプションに記述されたスタイルに従って口笛とか鼻歌のメロディーを変換できることも実証されています。現在は今後の研究を支援するために、5,521の音楽サンプルと英語で書かれた曲の音楽の様相リスト、ミュージシャンによる文章の組み合わせからなるデータセットも公開されているそうです。

あっこゴリラ:そもそも内蔵されているデータが1人の人間よりも明らかにとんでもない量じゃないですか。だからそこに関しては信用できちゃいますよね。

一方で、Google ReseachはAIが生成した音楽には著作権侵害など倫理的な課題があることも指摘しているという。

Fukunaga:MusicLMでAIが生成した音楽の約1%が著作権のある素材をそのまま使用していることが認められているみたいで、Googleは音楽生成に関してのリスクを認識して、今後の研究でその辺を改善していく必要があると述べています。

現在のAIと音楽の関係性について語ってくれたFukunagaに、あっこゴリラは「今後はAIが作曲化などのクリエーターの仕事を奪う可能性はあるか?」と質問した。

Fukunaga:今、それはよく言われている話なんですけど、クリエーターに限らず多くの分野で働いている方が抱えていることだと思います。ただ現時点で、AIはターミネーターとかドラえもんみたいなもののように何でもできるみたいなものではないと、去年自分が取材したAI識者は認識しているようです。とはいえ、AIの進化のスピードは識者からしても予測がつかないくらい加速しているので、将来的にどうなるかわからない部分は確かにあります。ただ、開発者とか研究者たちは人の仕事を奪うことよりも人の可能性を拡張することをテーマに研究・開発しているので、そのコンセプトで使うものはどんどん増えていくと思います。

J-WAVE『SONAR MUSIC』は、月~木の22:00-24:00にオンエア。

Fukunagaが登場したのはJ-WAVEで放送された番組『SONAR MUSIC』(ナビゲーター:あっこゴリラ)。オンエアは3月15日(水)。

【SONAR MUSICは番組公式LINEでも情報発信中! 登録はコチラ】

https://page.line.me/181xnepk?openQrModal=true

AIがエミネム音声を生成!?

ジャンルを指定するだけでAIが作曲してしまう時代に突入。AIによって音楽業界はどんな進化を遂げていくのか。AIは音楽家の仕事を奪ってしまうのか。今回はFukunagaが、最近のAIと音楽との注目トピックを紹介しながらあっこゴリラとトークを展開した。まずFukunagaは「デヴィッド・ゲッタ、AIと音楽の関係について持論を語る」というトピックを紹介した。

有名EDMプロデューサーでDJのデヴィッド・ゲッタは、AIが生成したラッパーのエミネムの声を使用した楽曲『Emin-AI-em』を紹介する動画をSNSで公開したことで注目を集めた。

Let me introduce you to… Emin-AI-em pic.twitter.com/48prbMIBtv

— David Guetta (@davidguetta) February 3, 2023

あっこゴリラ:これめちゃくちゃ話題になりましたよね。

Fukunaga:結局、議論も呼び起こしていて、その動画でデヴィッド・ゲッタは、AIが作ったエミネムの楽曲について「エミネムの音声はAIを使用したんだけど、冗談で作ったものだ」と説明してるんです。この曲はデヴィッド・ゲッタが出演したあるイベントでプレイされているんですけど、今後商業ベースで使用されることはないと言っています。彼自身はAIを音楽制作の道具として利用することに肯定的なんですよね。新しい音楽制作スタイルを生み出す可能性があると考えているんです。ただ、アーティストのセンスに代わるものではなくて、あくまで道具として利用するべきだとも述べています。ただ、AIを使うことにアーティストでも賛否両論あるんですよね。

あっこゴリラ:それはそうですよね。

Fukunaga:例えば、大御所アーティストのニック・ケイヴとかは否定的な見解を示しています。とはいえ音楽の歴史を振り返っていくと、ローランドのTR-808が出てきたりとかで新しいテクノロジーが導入されたことで生まれた音楽スタイルってあるじゃないですか。まさにヒップホップとかトラップとかも正にそうだと思うんですけど。だからデヴィッド・ゲッタが言うようにAIにもそういうことが起きうるはずだって感じなんですよね。

あっこゴリラ:確かに。人類ってもうAIなしの生活は厳しいんじゃないかなって。できるとは思うんだけど、効率化する上でもかなりいいし。だからポジティブになるべく仲よくやっていきたいですよね。でも気をつけないといけないのはAIに食われないことですよね(笑)。そこだけはマジで気をつけながらっていうのがポイントかなって。でもそこで新しい音楽スタイルが生まれるのはちょっと楽しみですよね。何が生まれるのかなって。

知らず知らずにAIを使って音楽を聴いている

続いてFukunagaは「AI音声によって歌われた楽曲のストリーミング数が1億回を突破したことが明らかに」というトピックを紹介した。中国のTencent Music Entertainment(TME)が、人間の声を模倣したAIによるボーカルをフィーチャーしてリリースした楽曲が、1億回ストリーミング再生を突破したことを発表した。

Fukunaga:ちなみにSpotifyで1億回のストリーミングをされたときの収益は役4,763万円相当って言われています。

あっこゴリラ:スゴすぎる。

Fukunaga:TMEの音楽部門ってこれまでにAIボーカルをフィーチャーした曲を1000曲以上出してるそうで、そのうちの『Today(英題)』という曲、それが1億回以上ストリーミングされた最初のAIの曲になったとのことなんです。またTMEは2022年11月の段階で、中国の音楽シーンにおけるスターの声を使ったAI歌手のラインナップ確立に取り組むことも発表したりもしているんです。同様の動きとして、BTSが所属しているHYBEがAI音声デベロッパーの会社を買収したこととかもあったりして、この辺も今後どんどん動いていきそうな業界の話ですね。

あっこゴリラ:なるほど。

Fukunaga:こういういわゆるディープフェイクみたいなものはまだ倫理とか法律の問題もあるので、今生きている人の声を勝手には使うことができないっていうことがあって。さっきのデヴィッド・ゲッタの話もそうで、これで商業リリースはできていない気はするんですよね。

あっこゴリラ:人ごとじゃないっていうか。私も声の商売なので、勝手に使われるってなると「ちょっと待て」ってなってきちゃいますよね。

「こうなるとボカロもどうなるのかと」とあっこゴリラがFukunagaに質問する。

Fukunaga:ボカロもCeVIO AIってAIの人口合成音声を出すっていうものがすでにあるので、利用者も多いんじゃないですかね。

あっこゴリラ:マジでターミネーターじゃんって気がする。音楽業界がターミネーター化してるっていうか。

Fukunaga:意外と音楽業界ってあまり気にしてないだけで、AIってみんな使ってるんですよね。例えばサブスクのパーソナライズとかもそうですし、音楽を作るときのプラグインとかもAIのアシストツールが付いてたりするので。

あっこゴリラ:だからトレンドだけ追いかけてたらAIに取って変わられる気はしますね。

人の仕事を奪うことよりも人の可能性を拡張すること

Fukunagaが次に「Googleが文章から音楽を作れる最新音楽生成AIツール『MusicLM』を発表」というトピックをセレクトした。Fukunaga:Googleの研究部門にGoogle Researchっていうところがあって、そこが今年公開したツールなんですけど、入力された文章に応じてAIが音楽を自動で生成するというツールです。28万時間に及ぶ音楽のデータセットを用いて学習したAIが使われていて、Googleは非常に複雑なテキストからでも忠実生の高い音楽が作り出せると言っています。例として「ディストーションの効いたギターリフのバッキングにのった心地よいバイオリンの旋律」みたいな複雑な文章にも対応するとされてるんですよ。

あっこゴリラ:「むせび泣くような」とか、感情的な部分も反応してくれるんですか。

Fukunaga:そういうのもやってて、このMusicLMはテキストとメロディーの両方を条件とすることができるんですよ。文章のキャプションに記述されたスタイルに従って口笛とか鼻歌のメロディーを変換できることも実証されています。現在は今後の研究を支援するために、5,521の音楽サンプルと英語で書かれた曲の音楽の様相リスト、ミュージシャンによる文章の組み合わせからなるデータセットも公開されているそうです。

あっこゴリラ:そもそも内蔵されているデータが1人の人間よりも明らかにとんでもない量じゃないですか。だからそこに関しては信用できちゃいますよね。

一方で、Google ReseachはAIが生成した音楽には著作権侵害など倫理的な課題があることも指摘しているという。

Fukunaga:MusicLMでAIが生成した音楽の約1%が著作権のある素材をそのまま使用していることが認められているみたいで、Googleは音楽生成に関してのリスクを認識して、今後の研究でその辺を改善していく必要があると述べています。

現在のAIと音楽の関係性について語ってくれたFukunagaに、あっこゴリラは「今後はAIが作曲化などのクリエーターの仕事を奪う可能性はあるか?」と質問した。

Fukunaga:今、それはよく言われている話なんですけど、クリエーターに限らず多くの分野で働いている方が抱えていることだと思います。ただ現時点で、AIはターミネーターとかドラえもんみたいなもののように何でもできるみたいなものではないと、去年自分が取材したAI識者は認識しているようです。とはいえ、AIの進化のスピードは識者からしても予測がつかないくらい加速しているので、将来的にどうなるかわからない部分は確かにあります。ただ、開発者とか研究者たちは人の仕事を奪うことよりも人の可能性を拡張することをテーマに研究・開発しているので、そのコンセプトで使うものはどんどん増えていくと思います。

J-WAVE『SONAR MUSIC』は、月~木の22:00-24:00にオンエア。

この記事の続きを読むには、

以下から登録/ログインをしてください。

radikoで聴く

2023年3月22日28時59分まで

PC・スマホアプリ「radiko.jpプレミアム」(有料)なら、日本全国どこにいてもJ-WAVEが楽しめます。番組放送後1週間は「radiko.jpタイムフリー」機能で聴き直せます。

番組情報

- SONAR MUSIC

-

月・火・水・木曜22:00-24:00

-

あっこゴリラ